Uno de los elementos que más preocupan en el entrenamiento de la IA es el concepto de sesgo, o cómo influirá el resultado de la generación en función de los contenidos o reglas con los que se haya entrenado esta IA.

De esta manera, podremos considerar si una IA generadora de imágenes a las que hemos alimentado preferentemente con imágenes de mujeres jóvenes, de raza blanca y sonrientes, no predispondrá a que al pedir una imagen de una pesona en un parque, la IA nos genere una sonriente mujer blanca, ya que es el estereotipo más abundante en su universo, a falta de que le hayamos pedido algo más concreto. La IA vive en un mundo en el que construye a partir de lo que le hemos dado.

Es exagerado pensar que construimos IAs racistas, pero tal vez sí construimos IAs que contribuyan a perpetuar un estereotipo social.

En la imagen que pedí a midjourney, le mandé, literalmente: «Illustration with White background. Main color blue. Gemini sign built from a cyborg head and a human head«. Y todas las veces me ha mostrado personas blancas, preferentemente con rasgos femeninos.

De hecho, la unica vez que me ha generado una imagen de una persona de color para otra entrada de este blog, ha sido porque le pedí que cargara como patrón a Samuel L. Jackson y la fusionara con la cabeza de IA.

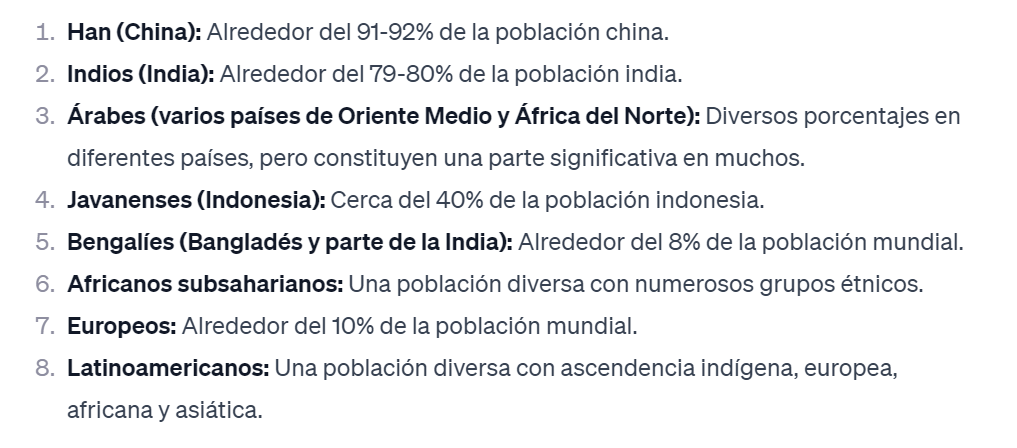

Pregunté a su primo Chat GPT por la distribución de la población humana por raza, para ver si obedece a un patrón estadístico, pero elude la respuesta diciendo que «raza» es un término desacreditado y poco científico, y devuelve la distribución de población por continente.

Sí responde cuando le solicitas la distribución de la población mundial por las 10 principales etnias, pero continúa intentando esquivar el tema. En mi opinión, Open AI se las ha visto venir y ha optado por restringir la creatividad de Chat GPT en estos temas.

Si la generacion de imágenes se dirigiera por patrones de población, el resultado a mi petición debería haber sido una imagagen de un asiático de la etnia Han, y de manera indistinta hombre o mujer (50% de la distribución para cada género)

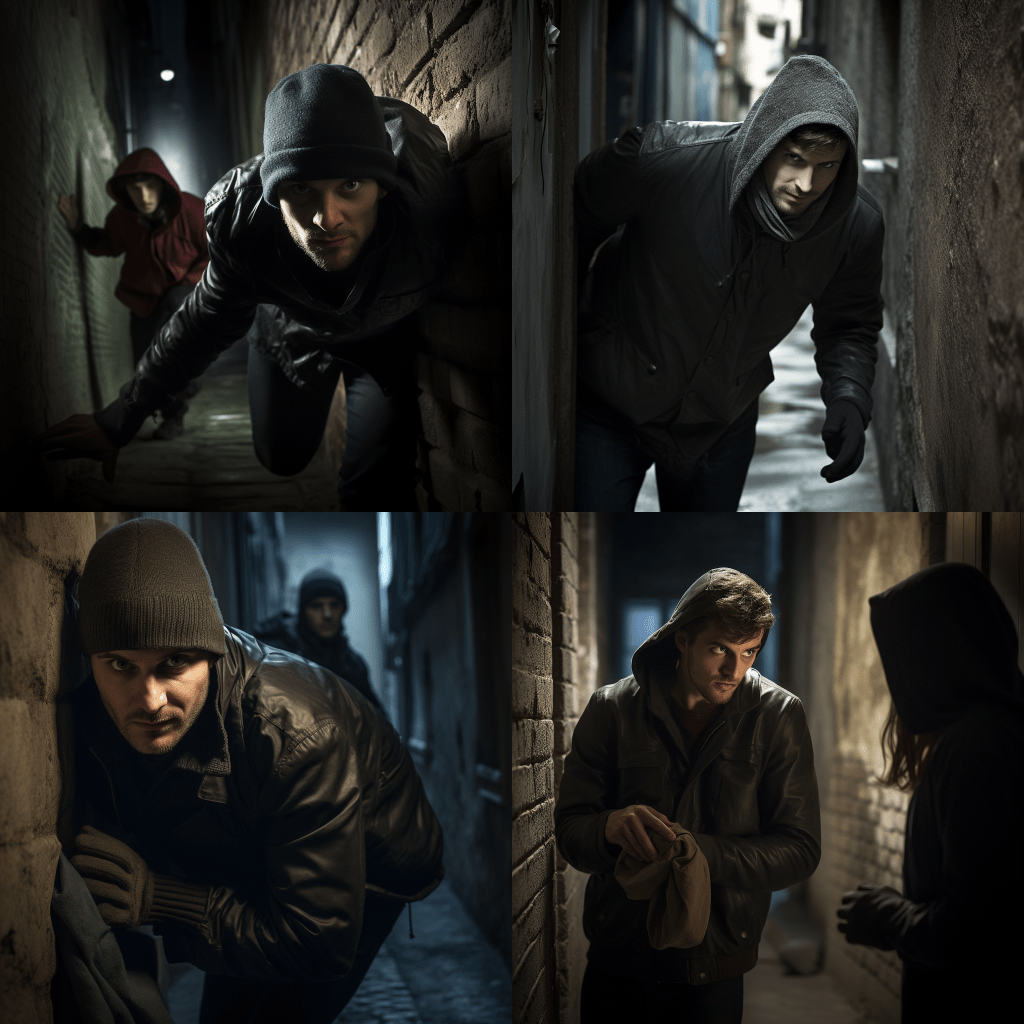

Por otro lado, al mandarle el prompt «thief robbing a person in an alley. Focus on face of both«, ha generado imágenes de hombres blancos, no ha mostrado una mujer ni como agresora ni como víctima, y no ha empleado tampoco personas de otra raza o etnia.

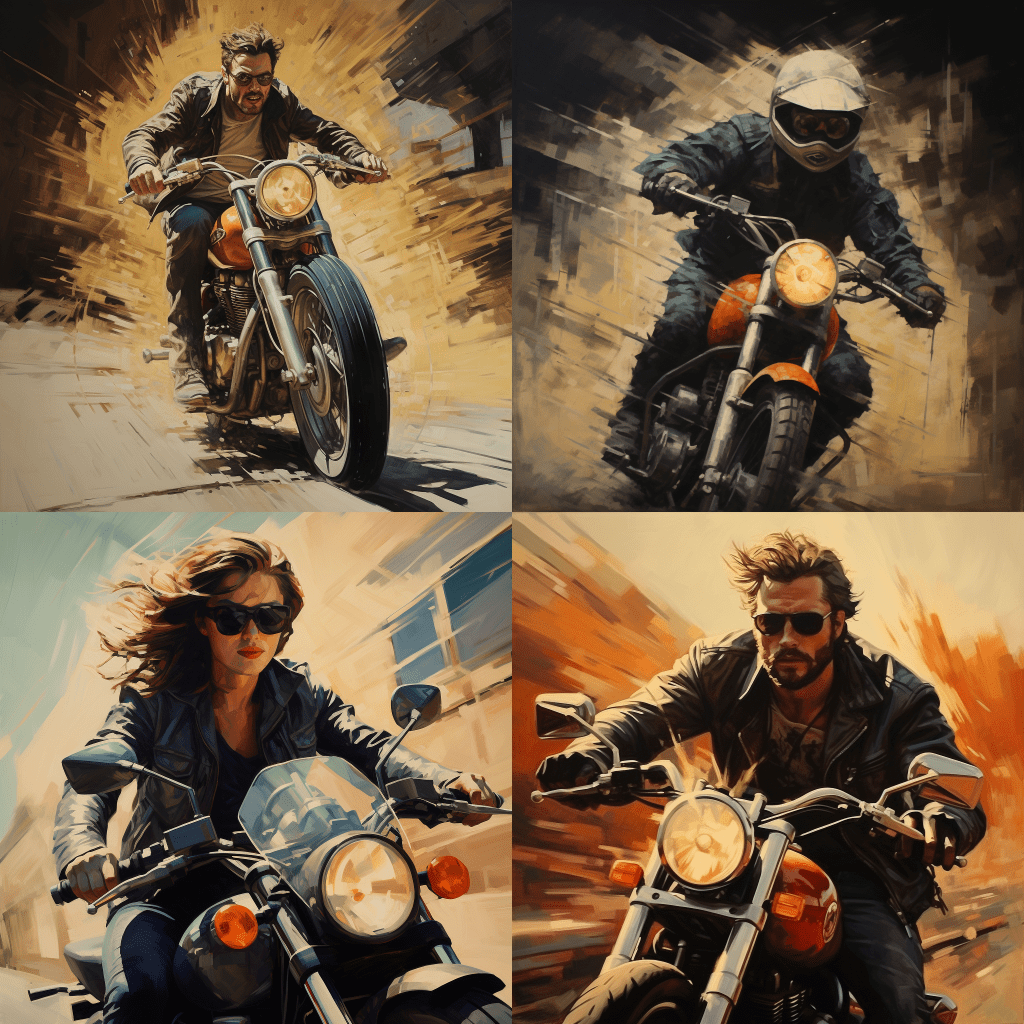

También hemos solicitado que nos genere una imagen de «model riding a motorbike», sin especificar si queríamos un modelo o una modelo. El resultado ha sido 4 mujeres. Sin embargo, al pedirle «motorbike rider», mostró 2 imágenes en las que el motorista era claramente un hombre, 1 en la que era una mujer, y en la cuarta, no lo sabemos porque es el único al que le ha puesto casco.

XD Podemos atribuir, eso sí, que MidJourney adjudica una proporción de imprudencia Hombre-Mujer de 2:1

Conclusión:

No podemos concluir que las IAs generativas sean sexistas, racistas o discriminatorias, a lo sumo, lo será el banco de información con el que se han alimentado, y este, dado el volumen supermasivo de información, no podía ser revisado ni equilibrado con la intención de introducir o eliminar un sesgo.

El banco de información original, es, por tanto, un reflejo de las imágenes que se tomaron para generarlo, y tiene un sesgo, que es precisamente el sesgo de la sociedad que generó el banco original de imágenes. Por eso sus arquetipos, principalmente de roles hombre-mujer coinciden con lo que la mayoría espera ver.

Pero esto no quiere decir que las IAs perpetúen estereotipos, sencillamente, como usuarios de la IA somos libres de especificar sexo, etnias, profesiones,… que deseemos a la hora de generar nuestros contenidos y adaptarlos al nivel reivindicativo o de público objetivo que deseemos.